Los robots ya no son sólo un instrumento de las fábricas de producción masiva, sino que se están integrando rápidamente a nuestras vidas. El ministerio japonés de economía (METI) predice el surgimiento de una sociedad neo-mecatrónica, en la cual los robots participarán en actividades recreativas, de limpieza y cuidado a la salud de la senectud. Sumado a lo anterior, en los Estados Unidos se anticipa la inclusión de los robots en tareas cooperativas con humanos en los siguientes ámbitos: cuidado a la salud, agricultura, energía, defensa y exploración espacial (Royakkers, M & Est, 2016).

Rosalind Picard (1997) menciona en su libro

Affective Computing, algunos de los problemas que pueden surgir al dotar a las computadoras con habilidades de respuesta, entendimiento y expresión afectiva. Sin embargo la autora considera que el desarrollo del cómputo afectivo es necesario para que las computadoras interactúen de forma natural con los seres humanos.

Se observa que la vida humana, en todas sus dimensiones está arrojada en un entorno tecnológico, pues el ser humano no vive ya en la naturaleza, sino que está alojado en la sobrenaturaleza que ha creado, en un nuevo día del génesis: la técnica (Gasset, 1992). Comprender las implicaciones de las innovaciones de la técnica es un asunto político, filosófico y ético, por lo cual es menester preguntarse por las consecuencias de su uso. El entorno tecnológico del siglo XXI nos enfrenta a nuevas formas de interacción con las computadoras, por ello es de gran importancia anticiparse a las implicaciones éticas del cómputo afectivo y la inteligencia artificial.

El presente escrito tiene como propósito iniciar una discusión sobre los problemas éticos del cómputo afectivo, delimitado por Picard (1997) como un marco de investigación y desarrollo enfocado en dotar a las computadoras de habilidades emocionales. Para cumplir este propósito realizaremos una reflexión ética y filosófica sobre dos problemas potenciales de los agentes afectivos artificiales: la descalificación social y el antropomorfismo computacional.

“Nuestras experiencias son siempre intersubjetivas, lo cual significa que cuando estamos en el mundo estamos necesariamente con los demás. Pensar en seres humanos aislados es imposible”. (García & Traslosheros, 2012). Además, para relacionarnos con los otros hacemos uso de nuestras habilidades emocionales. En el caso de los niños esto es más notorio, pues se comunican solamente a partir de expresiones emocionales (i.e. gritos, llanto, y risas) antes de adquirir completamente un lenguaje (Picard, 1997). Lo anterior nos enfrenta a la cuestión de la influencia del cómputo afectivo en el desarrollo emocional de los niños, toda vez que los agentes emocionales artificiales, al interactuar con ellos pueden acrecentar la descalificación social.

La descalificación social hace referencia a uno de los efectos que la mecanización de la interacción humana provoca: la erosión de las habilidades necesarias para mantener relaciones sociales. Según Sparrow (2002), la imitación (de emociones en los robots y computadoras) es un peligro ético potencial, pues podríamos confundir a nuestras creaciones por lo que no son. Respecto a este problema el psicólogo Sherry Turkle (2002) predice lo siguiente: los niños se acostumbrarán a las amistades casi perfectas de los robots (programados positivamente), y por lo tanto no aprenderán a lidiar con las personas de su vida cotidiana, así como con sus problemas y malos hábitos.

Los problemas mencionados anteriormente se deben en gran parte a que las personas le asignan estatus psicológicos y morales a los robots o programas, cuando previamente eran sólo atribuidos a seres humanos (Melson et. al, 2009). En Royyakkers et al. (2016) se muestra cómo esto influye el desarrollo social y emocional de los niños, puesto que cada vez están más en contacto con este tipo de tecnologías.

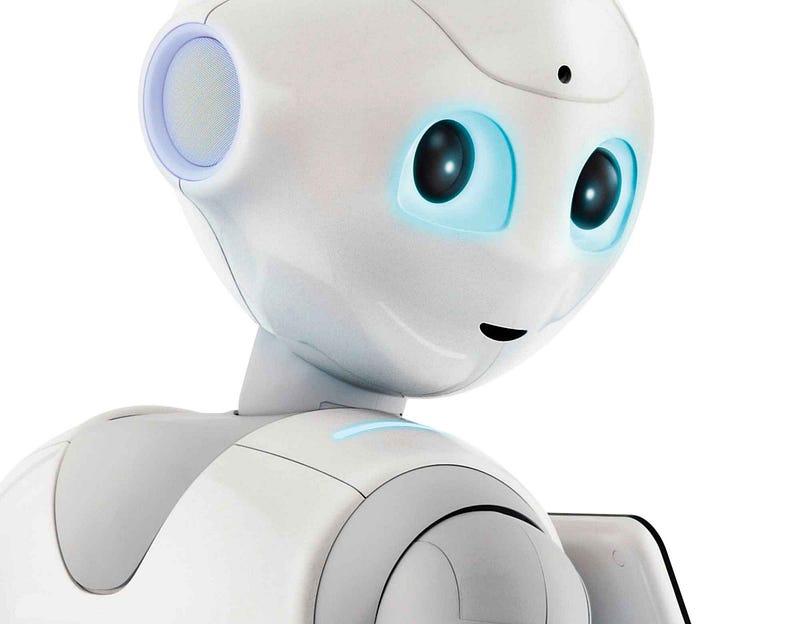

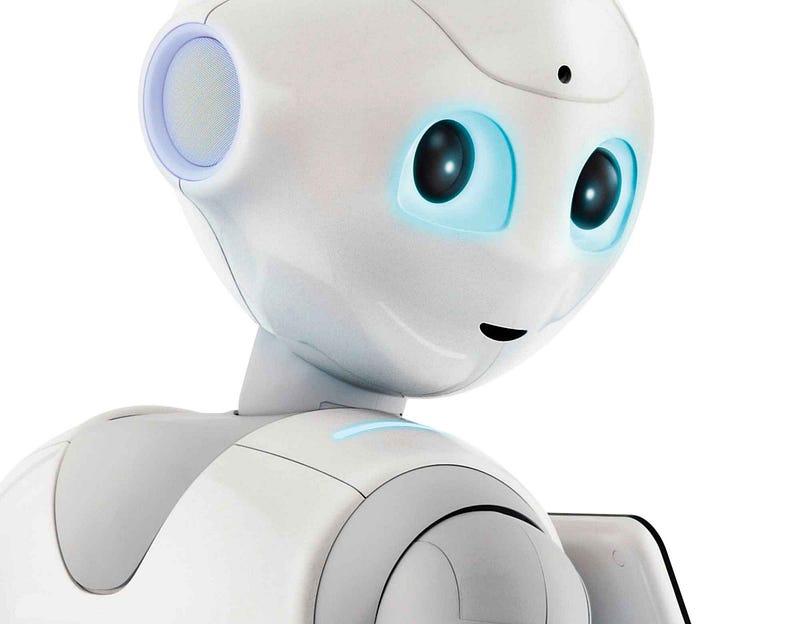

La descalificación social en niños es un problema potencial de los nuevos robots emocionales, como

NAO (“ASK NAO Autism Solution for Kids”, 2017) y

Pepper (“Who is Pepper?”, 2017). Ambos cuentan con distintos sensores y programas configurables capaces de responder afectivamente y reconocer emociones. Sin embargo, aunque uno de los propósitos de estas herramientas sea auxiliar el desarrollo emocional de los niños, se deben tomar consideraciones respecto a su uso educativo antes de implementar la solución.

Robot Pepper

Pearson et al. (2014) mencionan que diseñar robots educativos para los niños requiere que prestemos mucha atención a las formas en que las características particulares del diseño influyen el desarrollo a corto y a largo plazo. Esto se debe a que la interacción humano-robot tiene el potencial de alterar no solo el desarrollo mental de los niños, sino también sus interacciones con otros seres humanos. Las decisiones de diseño deben realizarse de manera que puedan promover su salud física, psicológica y emocional. Por lo tanto, todo el procedimiento de creación de tecnología afectiva debe ser analizado desde una perspectiva interdisciplinaria que incluya tanto humanidades como ciencias.

Por otra parte el antropomorfismo de los agentes emocionales artificiales tiene consecuencias en la calidad del juicio que hacemos sobre la información proporcionada por computadoras. Rosalind Picard (1997) menciona que es común que confiemos en el resultado de una máquina o computadora ya que es predecible y no presenta sesgos (que no hayan sido propósito de su diseño per se). Sin embargo no existe razón suficiente para que una computadora afectiva sea incapaz de mimetizar los rasgos emocionales, y utilizar este procedimiento para engañar y extraer información privada. Ergo: para mantener la integridad humana con la tecnología afectiva, sus diseñadores deben tomar en cuenta las limitaciones de las computadoras al reconocer emociones y evitar así que sean utilizadas para dar falsas impresiones a los usuarios.

Un caso particular de los efectos del antropomorfismo computacional es Siri, el asistente personal de Apple. Sus diseñadores lo dotaron con capacidades para atender al ser humano a través del lenguaje natural, pero en ocasiones no funciona como se espera. José Mendiola enfatiza el problema de fiabilidad que enfrenta Siri no sólo al entender a sus usuarios, sino también para proveer respuestas pertinentes (Mendiola, 2016). Esto es sólo un caso de un sistema de asistencia personal que aún no implementa completamente las posibilidades del cómputo afectivo, como es el caso de Samantha en la película

Her (2013), no obstante las empresas que utilizan agentes conversacionales artificiales deben hacer una revisión ética de su funcionamiento; tenemos antecedentes suficientes con el chatbot que respondía violentamente en Twitter (Wakefield, 2016).

Theodore Twombly con Samantha

La inteligencia artificial está más cerca de superar la prueba de Turing (“Computer AI passes Turing test in ‘world first’ “, 2014). A medida que nos acercamos a este límite racional, la necesidad por una ética de la inteligencia artificial se hace más evidente. Por ello es necesario hacer una revisión ética de la tecnología y la ciencia.

Dado lo anterior, no podemos desentendernos del efecto que tienen nuestras emociones sobre los otros para vivir en sociedad, ni mucho menos de los efectos de la tecnología en el desarrollo emocional, toda vez que éstas son utilizadas para formar vínculos con otras personas y mantener la equidad entre las mismas a través de la empatía. Las emociones impactan la totalidad de la experiencia humana, incluyendo la creatividad, la toma de decisiones y la inteligencia. Generalmente se cree que las emociones no tienen que ver con la inteligencia, pero las diversas investigaciones (Simon, 1967; Hofstadter & Dennett, 1981; Gelernter, 1994;) en el campo de las ciencias cognitivas demuestran que las emociones tienen gran impacto en: creatividad, memoria, resolución de problemas, humor y percepción. Nos hemos quedado con la cara negativa de la emoción, tomándola sólo como irracionalidad caprichosa, cuando el ser humano es un ser racional-emocional que la incorpora en su hacer cotidiano.

Concluimos que la tecnología no es un ente neutral; esta creencia nos ha llevado a la idealización de la tecnología como herramienta que puede resolver cualquier problema sin considerar completamente su naturaleza. La idealización de la tecnología nos aleja del juicio de valor y propósito embebido en su diseño (Bateman, 2015). Un objeto no es bueno sólo por ser tecnológico, pues cada objeto que hemos diseñado cambia las razones y las posibilidades del actuar, y esto impacta la esfera personal y social. El pensamiento que divide categóricamente objetos y sujetos tiene sus orígenes en las epistemología kantiana, pero se ha llevado al extremo, a tal grado que el sujeto recibe un estatus moral especial aislado de los objetos, productos que el sujeto realiza para lograr sus respectivos fines. En otras palabras, ignoramos la influencia del objeto tecnológico en el actuar del sujeto tratándolo como un medio moralmente neutro, cuando las posibilidades de ser bueno o malo se incrementan con la tecnología.

Entonces el problema ético que se avecina no es el de las computadoras ganando el estatus de sujeto, (sustituyendo al ser humano mediante la adquisición de emociones, o llevando a cabo la actividad de pensar) sino el del control que los sistemas tienen sobre sus facultades para garantizar el bienestar del ser humano. Tenemos que empezar a asignar responsabilidades a cada aspecto y elemento del desarrollo y uso de la tecnología. No tenemos excusa ni siquiera frente al comportamiento inadecuado de la inteligencia artificial más avanzada, pues ¿Si las computadoras adquieren autonomía y se vuelven no deterministas, cómo podremos evitar catástrofes y tomar control sobre nuestro propio hacer-tecnología? ¿Quiénes serán los responsables si estos objetos tecnológicos heredan la ética del sujeto y la implementan automáticamente en nuevos objetos (como la máquina autorreplicante de Von Neumann, 1966)? Si todas estas cuestiones no se atienden a tiempo, conforme una ética que traslade completamente la responsabilidad del sujeto al proceso tecnológico, los resultados serán fatales, tan desastrosos como los que provoca el descontrol emocional del ser humano.

Máquina autorreplicante

Referencias

- ASK NAO Autism Solution for Kids. (2017). Recuperado en April 19, 2017, de http://www.robotlab.com/store/ask-nao-autism-solution-for-kids

- Bateman, C. (2015). We Can Make Anything. Rethinking Machine Ethics in the Age of Ubiquitous Technology Advances in Human and Social Aspects of Technology, 15–29. doi:10.4018/978–1–4666–8592–5.ch002

- Computer AI passes Turing test in ‘world first’ (2014, Junio 09). Recuperado en Abril 19, 2017, fre dm http://www.bbc.com/news/technology-27762088

- García & Traslosheros (2012). Ética, persona y sociedad: una ética para la vida. México, D.F.: Porrúa.

- Gasset, J. O. (1992). Meditación de técnica y otros ensayos sobre ciencia y filosofía. Madrid: Alianza.

- D. Gelernter. (1994). The Muse in the Machine. Ontario: The Free Press, Macmillan, Inc.

- Hofstadter, D. R., & Dennett, D. C. (1981). The Mind’s I. London: Penguin books.

- Jonze, S. (Director). (2013). Her [Video]. Estados Unidos: Warner Bros. Pictures.

- Melson, G. F., Kahn, Jr., P. H., Beck, A. and Friedman, B. (2009), Robotic Pets in Human Lives: Implications for the Human–Animal Bond and for Human Relationships with Personified Technologies. Journal of Social Issues, 65: 545–567. doi:10.1111/j.1540–4560.2009.01613.x

- Mendiola, J. (2016, October 16). Siri, ¿por qué no me comprendes? Recuperado en Abril 19, 2017, de https://www.applesfera.com/analisis/siri-por-que-no-me-comprendes

- Pearson, Y. & Borenstein, J. AI & Soc (2014) 29: 23. doi:10.1007/s00146–012–0431–1

- Picard, R. W. (1997). Affective computing. MIT Press.

- Royakkers, L. M., & Est, Q. C. (2016). Just ordinary robots automation from love to war. Boca Raton: CRC Press, Taylor & Francis Group.

- Simon, H. A. (1967). Models of man: social and rational ; mathematical essays on rational human behavior in society setting. New York: Wiley.

- Sparrow, R. ( 2002). The March of the robot dogs. Ethics and Information Technology, 4(4), 305–318. doi:10.1023/A:1021386708994

- Turkle, S. (2013). Alone together: why we expect more from technology and less from each other. Cambridge, MA: Perseus Books.

- Von Neumann, J. (1966). A. Burks, ed. The Theory of Self-reproducing Automata. Urbana, IL: Univ. of Illinois Press.

- Wakefield, J. (2016, March 24). Microsoft chatbot is taught to swear on Twitter. Recuperado en April 19, 2017, de http://www.bbc.com/news/technology-35890188

- Who is Pepper? (2017). Recuperado en April 19, 2017, de https://www.ald.softbankrobotics.com/en/cool-robots/pepper